- · 《语言研究》栏目设置[09/30]

- · 《语言研究》数据库收录[09/30]

- · 《语言研究》投稿方式[09/30]

- · 《语言研究》征稿要求[09/30]

- · 《语言研究》刊物宗旨[09/30]

E2E视觉语言预训练模型SOHO;微软分层ViT模型霸榜

作者:网站采编关键词:

摘要:机器之心 ArXiv Weekly Radiostation 参与:杜伟、楚航、罗若天 本周的重要论文包括?UC 伯克利等机构的研究者使用一种名为 PlenOctrees 的数据结构;微软亚研的研究者提出的通过移动窗口(

机器之心 & ArXiv Weekly Radiostation

参与:杜伟、楚航、罗若天

本周的重要论文包括?UC 伯克利等机构的研究者使用一种名为 PlenOctrees 的数据结构;微软亚研的研究者提出的通过移动窗口(shifted windows)计算的分层视觉 Transformer;北京大学、中山大学、微软亚研等机构的研究者提出的 Seeing Out of tHe bOx(SOHO)的概念,实现中文翻译即「开箱即看」等。

目录:

BART based semantic correction for Mandarin automatic speech recognition system

PlenOctrees for Real-time Rendering of Neural Radiance Fields

Swin Transformer: Hierarchical Vision Transformer using Shifted Windows

MobileStyleGAN: A Lightweight Convolutional Neural Network for High-Fidelity Image Synthesis

Convolutional Neural Opacity Radiance Fields

Seeing Out of tHe bOx: End-to-End Pre-training for Vision-Language Representation Learning

Self-supervised Video Representation Learning by Context and Motion Decoupling

ArXiv Weekly Radiostation:NLP、CV、ML 更多精选论文(附音频)

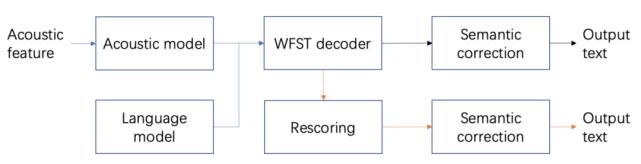

论文 1:BART based semantic correction for Mandarin automatic speech recognition system

作者:Yun Zhao、Xuerui Yang、Jinchao Wang 等

论文链接: ASR 转写结果中,仍然存在一些对人类来说非常明显的错误。我们并不需要听音频,仅通过观察转写的文本便可发现。对这类错误的纠正往往需要借助一些常识和语法知识,甚至推理的能力。得益于最近无监督预训练语言模型技术的发展,基于纯文本特征的纠错模型可以有效地解决这类问题。本文提出的语义纠错系统分编码器和解码器两个模块,编码器着重于理解 ASR 系统输出文本的语义,解码器的设计重在使用规范的词汇重新表达。

集成语义纠错模型的 ASR 系统。

集成语义纠错模型的 ASR 系统。

推荐:拼写、常识、语法、推理错误都能纠正,云从提出基于 BART 的语义纠错方法。

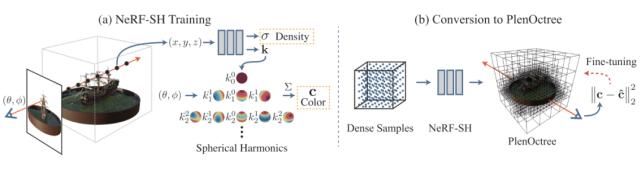

论文 2:PlenOctrees for Real-time Rendering of Neural Radiance Fields

作者:Alex Yu、Ruilong Li、Matthew Tancik 等

论文链接: 3D 视角物体和场景新视图是很多 VR 和 AR 应用的基础。近年来神经辐射场(Neural Radiance Fields, NeRF)的神经网络渲染研究通过神经网络编码实现了真实的 3D 视角场景渲染。但是 NeRF 需要极端的采样要求和大量的神经网络运算,导致其渲染速度十分缓慢,严重制约了其在实际场景,尤其是实时交互场景中的应用。例如,使用 NeRF 在高端 GPU 上渲染一张 800X800 像素的图片大概需要 30 秒。

近日,来自 UC 伯克利等机构的研究者使用一种名为 PlenOctrees 的数据结构为 NeRF 引入了一种新的数据表示,实现了实时的 NeRF 渲染。其渲染速度比原始的 NeRF 提高了 3000 多倍,并且图像质量可以与 NeRF 媲美。采用 PlenOctrees 结构还能有效减少 NeRF 的训练时间。

算法框架图。

算法框架图。

推荐:实时高保真渲染,基于 PlenOctrees 的 NeRF 渲染速度提升 3000 倍。

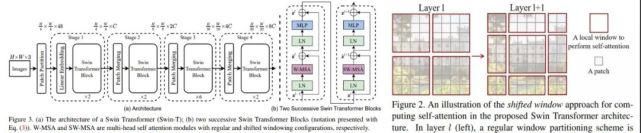

论文 3:Swin Transformer: Hierarchical Vision Transformer using Shifted Windows

作者:Ze Liu、Yutong Lin、Yue Cao 等

论文链接: 2017 年 6 月谷歌提出 Transformer 以来,它便逐渐成为了自然语言处理领域的主流模型。最近一段时间,Transformer 更是开启了自己的跨界之旅,开始在计算机视觉领域大展身手,涌现出了多个基于 Transformer 的新模型,如谷歌用于图像分类的 ViT 以及复旦、牛津、腾讯等机构的 SETR 等。由此,「Transformer 是万能的吗?」也一度成为机器学习社区的热门话题。

不久前,微软亚研的研究者提出了一种通过移动窗口(shifted windows)计算的分层视觉 Transformer,他们称之为 Swin Transformer。相比之前的 ViT 模型,Swin Transformer 做出了以下两点改进:其一,引入 CNN 中常用的层次化构建方式构建分层 Transformer;其二,引入局部性(locality)思想,对无重合的窗口区域内进行自注意力计算。

Swin Transformer 架构图(左),移动窗口示意图(右)。

Swin Transformer 架构图(左),移动窗口示意图(右)。

推荐:霸榜多个 CV 任务,开源仅两天,微软分层 ViT 模型收获 2k star。

论文 4:MobileStyleGAN: A Lightweight Convolutional Neural Network for High-Fidelity Image Synthesis

作者:Sergei Belousov

论文链接: GAN 可以生成不同层次的细节,大到头部形状、小到眼睛颜色,它在高保真图像合成方面实现了 SOTA,但其生成过程的计算复杂度却非常高,难以应用于智能手机等移动设备。

近日,一项专注于基于样式的生成模型的性能优化的研究引发了大家的关注。该研究分析了 StyleGAN2 中最困难的计算部分,并对生成器网络提出了更改,使得在边缘设备中部署基于样式的生成网络成为可能。该研究提出了一种名为 MobileStyleGAN 的新架构。相比于 StyleGAN2,该架构的参数量减少了约 71%,计算复杂度降低约 90%,并且生成质量几乎没有下降。

文章来源:《语言研究》 网址: http://www.yyyjzzs.cn/zonghexinwen/2021/0419/857.html